Un algoritmo reduce el sesgo racial y de género en los sistemas de reconocimiento facial

Un equipo de investigadores ha conseguido reducir el margen de error de los resultados obtenidos en las pruebas con Inteligencia Artificial

EUROPA PRESS

Un equipo de investigadores del Instituto de Tecnología Massachusetts (MIT) ha conseguido desarrollar un algoritmo que reduce al 60% el sesgo racial y de género que resulta del entrenamiento del reconocimiento facial de la Inteligencia Artificial (IA).

Un informe del Laboratorio de Inteligencia Artificial y Ciencia Informática (CSAIL) del Instituto de Tecnología Massachusetts (MIT) se explica cómo un equipo de investigadores ha conseguido reducir el margen de error de los resultados obtenidos en las pruebas con Inteligencia Artificial (IA) de reconocimiento facial con respecto al género y a la raza de la muestra.

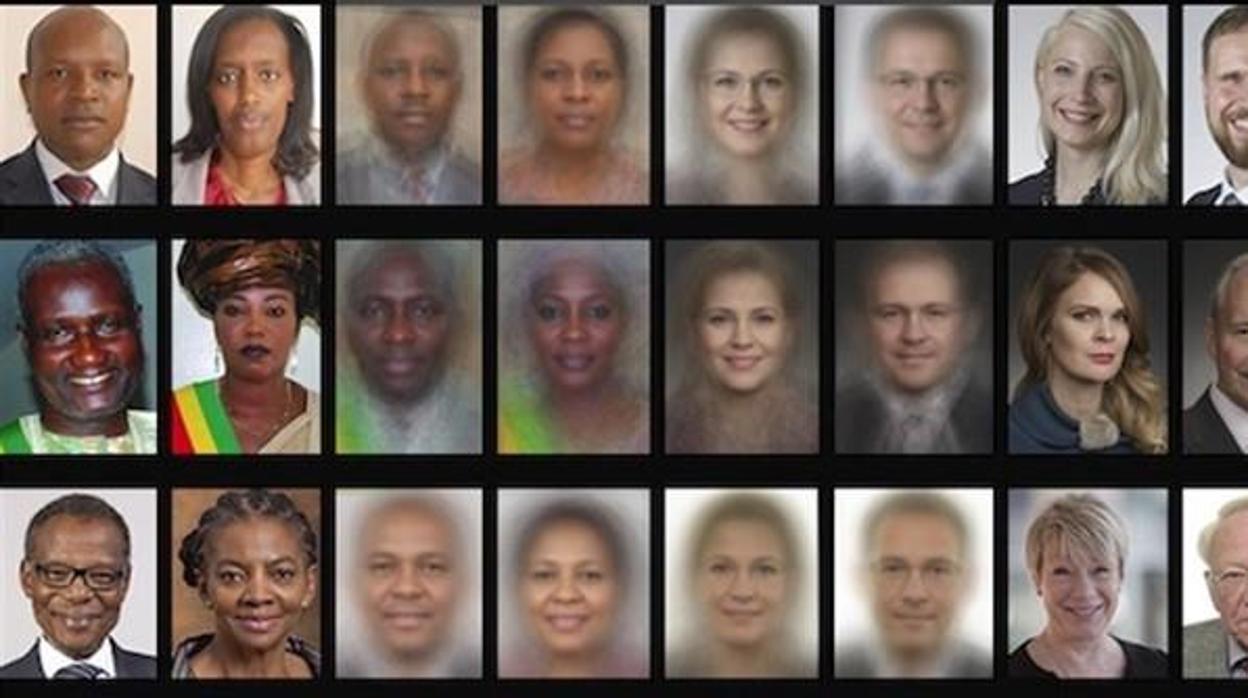

Un estudio del año pasado explicaba que el margen de error en el reconocimiento facial de la IA variaba dependiendo de la raza y el género del sujeto. Este estudio, basado en los sistemas de IBM Watson, Microsoft y Facebook, mostró que las fotografías de mujeres tienen un margen de error mayor que las de los hombres; error que aumenta, además, cuando el sujeto a analizar es de piel oscura.

Esta diferencia encuentra su explicación en la base datos sobre los que la IA basa su aprendizaje. Este sistema de datos cuenta con más muestras de hombres blancos que de mujeres negras, por lo que la Inteligencia Artificial tiene más dificultades a la hora de reconocer a los grupos de los que tiene menor referencia.

Un equipo del MIT ha avanzado en la solución de este problema al desarrollar un algoritmo que permite identificar y minimizar cualquier sesgo oculto, mediante el aprendizaje tanto de una tarea específica, como es el reconocimiento facial, como de la estructura implícita de los datos del entrenamiento. En las pruebas, para las que se ha empleado la misma base de datos que en el estudio del año pasado, el algoritmo redujo este «sesgo categórico» en más del 60% en comparación con otros modelos más avanzados de detección facial, sin que estos perdieran precisión.

El algoritmo puede analizar un conjunto de datos, aprender qué está intrínsecamente oculto en su interior y volver a muestrearlo para que sea más justo sin necesidad de que intervenga un programador humano. Alexander Amini , doctor del MIT y miembro del equipo a cargo del proyecto, explica la corrección del sesgo es «especialmente importante en tanto que empezamos a ver este tipo de algoritmos en seguridad, cuerpos policiales y otros dominios». Este sistema sería particularmente relevante, como añade Amini, para conjuntos de datos que son demasiado grandes para examinarlos manualmente.

Esta funcionalidad es sólo para registrados

Iniciar sesión